Un curso de Academia Addestra®. Explora éste blog y descubre cómo realizar instalaciones eléctricas residenciales más eficientes y seguras. ¡Descubre y aprende más aquí! ⚡🏠

Mostrando las entradas con la etiqueta tecnología. Mostrar todas las entradas

Mostrando las entradas con la etiqueta tecnología. Mostrar todas las entradas

Energía gravitacional con sello mexicano

2014/03/13

Inventor de tiempo completo a sus 50 años, el ingeniero Héctor Ricardo Macías comienza a destacar a nivel nacional por sus creaciones. Es precisamente una de ellas la que le abrió las puertas para comenzar a patentar los inventos que ha trazado durante horas de trabajo. Se trata del "Sistema para generar energía aprovechando el peso del flujo vehicular y peatonal", que en este momento se encuentra en fase de diseño, realizando prototipos.

En palabras del ing. Macías: "Aunque toda la vida nos han dicho que las plantas hidroeléctricas generan gran parte de la energía que consumimos, en realidad estamos partiendo de un error, ya que es la fuerza de gravedad la que produce la energía. El agua puede tener todo el potencial que se quiera, pero sin la atracción gravitacional que provoca la caída en los ríos y cataratas no se produce ninguna energía. Partiendo de esta idea es que nació este sistema, que aprovecha el peso que los vehículos, las personas y aún el ganado, ejercen sobre la corteza terrestre para presionar fuelles de perfil muy bajo, pero que al ser atacados por el peso generan aire a alta presión. A partir de ese paso sólo resta convertir el aire a presión en electricidad por medio de una turbina y un generador."

"A mediano plazo podemos pensar en una casa que instale sus "rampas escalón", simplemente pegadas en la calle con una manguera hacia el generador interior; tener generadores eléctricos en las tuberías del agua y una "planta generadora de viento solar" en la azotea." Un aspecto importante es que el sistema del ing. Macías puede instalarse en racks, de manera vertical, cosa que no puede hacerse con las celdas solares que tienen que armarse de manera horizontal y en ocasiones robando terreno que ya no puede usarse para la agricultura. La tendencia entonces es generar un poco de energía de cada sistema y así alimentar sustentablemente a los hogares. Al ser iguales las condiciones, podemos pensar que alimentar una casa, un parque o una carretera, se puede hacer sin ningún problema con estos sistemas, sin hacer adaptaciones mayores.

El "Sistema para generar energía aprovechando el peso del flujo vehicular y peatonal" no es el único invento de este ingeniero civil, también ha creado un Sistema para generar electricidad aprovechando la fuerza que tienen los líquidos al circular por las tuberías. "Este puede ser interesante también porque puede generar energía incluso con líquidos inflamables: podríamos pensar en electrificar comunidades cercanas al paso de oleoductos, por ejemplo. Tengo además otro sistema para generar electricidad con el agua de lluvia poniendo una turbina helicoidal en los tubos de bajada del agua".

Sistema para generar electricidad con el sol sin usar fotoceldas. "Las celdas aprovechan el paso de los fotones, o dicho de otra forma la parte luminosa de los rayos solares, pero dejan de lado el espectro calórico o infrarrojo de los rayos del sol. Mi invento consiste en turbinas que trabajan en capelos transparentes al vacío con papalotes pintados de negro matizado por una cara y de color plata metalizada la otra cara. Una cara absorbe más calor que la otra y tiende a alejarse, y al estar al vacío no tiene problemas en provocar la rotación de su eje y por lo tanto generar electricidad con el calor del sol, no con la luz como se hace ahora".

Todo el material requerido para inventar estos sistemas ha sido absorbido por el Ingeniero Héctor Ricardo Maclas, quien comenta que únicamente ha recibido apoyo por parte del Instituto Mexicano de la Propiedad Intelectual (IMPI) para patentar sus creaciones. Y califica a este proceso como fácil, "lo difícil viene con los planes de explotación y financiamiento para lograr llevarlos al mercado".

En este momento se encuentra buscando alguna propuesta que le permita sacar a la luz sus proyectos en el territorio mexicano. "Me recibido ofertas de dos países europeos, uno asiático y dos de Norteamérica, pero yo quiero que estas tecnologías se queden en México, pero de aquí nadie me ha hecho ninguna oferta de trabajo".

El Bosón de Higgs

2014/01/07

El origen del universo siempre ha sido un tema controversial, esto se debe a que aún hay mucho por investigar y con ello dar respuesta a las preguntas que se plantea la Física Moderna. Hasta el momento, el Modelo Estándar es la teoría aceptada por los físicos, que se utiliza para describir el comportamiento de las partículas elementales que componen el universo, los campos que existen, su interacción, y así entender el génesis y funcionamiento del mismo.

Sin embargo, existe un descubrimiento que ha venido a “completar una visión del universo”, aclarando una de las interrogantes más importantes: ¿Cuál es el origen de la masa (y por tanto de todo lo que podemos tocar y percibir, incluyendo al hombre)? La respuesta es el bosón de Higgs, más conocido como la partícula de Dios, hallazgo por el cual recientemente recibieron el Premio Nobel de Física Peter Higgs y François Englert, quienes desde hace 50 años predijeron la existencia de esta partícula.

El doctor Gerardo Herrera Corral, investigador titular del Departamento de Física del Centro de Investigación y de Estudios Avanzados (Cinvestav) del Instituto Politécnico Nacional (IPN), involucrado en el proyecto por el cual fue posible comprobar la existencia del bosón de Higgs, nos brinda una explicación sobre el tema: “El bosón de Higgs es una partícula asociada a un campo. En la actual concepción de la naturaleza, todo lo que forma a la materia son campos. Existen campos de materia, campos de fuerza y el campo de Higgs. El campo de Higgs es tal que al interaccionar con los campos de fuerza y los campos de materia, les confiere una resistencia al movimiento. A esta inercia es a lo que los físicos llamamos masa. El campo de Higgs se manifiesta como una partícula con espín* cero; por este hecho de tener espín cero, se le llama bosón”.

|

| Dr. Gerardo Herrera Corral, investigador titular del Departamento de Física del Cinvestav |

¿Qué relación tiene el bosón de Higgs con la electricidad? El bosón de Higgs surgió con la intención de dar masa a los bosones de la interacción débil, dejando al fotón sin masa. El fotón es el responsable de la interacción electromagnética que gobierna todos los fenómenos eléctricos.

Para hacer posible el descubrimiento de la partícula de Higgs, se requirió invertir en tecnología y en equipo humano. De ahí surgió el Gran Colisionador de Hadrones (LHC, por sus siglas en inglés). Gerardo Herrera lo describe como “un acelerador de partículas donde se llevan a cabo colisiones entre protones y entre iones pesados a altas energías jamás logradas. Tiene el potencial de dar respuesta a las preguntas más importantes que se plantea la física moderna como: la existencia de dimensiones extras más allá de las que percibimos, porqué el universo está hecho de materia y no de antimateria, cómo era el universo temprano, etcétera.

Ver también: La electricidad y el átomo

Es precisamente esta última interrogante una de las que se busca responder con el experimento ALICE, en el que se encuentra Gerardo Herrera como líder del grupo mexicano, compuesto por alrededor de 35 personas, entre estudiantes e investigadores provenientes de diferentes instituciones: Cinvestav del IPN, Universidad Autónoma de Puebla, Universidad de Sinaloa y Universidad Nacional Autónoma de México. Es “una oportunidad para nuestros jóvenes de formarse en un ambiente competitivo de muchas áreas de la ciencia y la tecnología”.

ALICE (A Large Ion Collider Experiment, el gran experimento colisionador de iones) es uno de los 4 experimentos que componen el LHC. Éste tiene la misión de crear plasma de quarks y gluones (QGP, por sus siglas en inglés), estado por el que transitó la materia primigenia del universo, los primeros instantes después del gran estallido conocido como Big Bang. Apenas transcurridos 10 microsegundos de la creación del cosmos, este QGP se enfrío, propiciando la formación de protones y neutrones que se encuentran en el interior de los núcleos atómicos. En este experimento además de acelerar las partículas, también se les desacelera, se les frena y estudia su comportamiento y el Universo Temprano, gracias a lo cual se podrá saber qué fue lo primero que sucedió cuando se creó el Universo.

También “el experimento ALICE investiga el mecanismo espontáneo de simetría que está en el fondo del origen de la masa. Es el mismo mecanismo que da origen al Higgs. El rompimiento de simetría que se estudia en ALICE se refiere al de la simetría quiral y es el responsable del 98% de la masa que nos rodea”.

Estos son algunos datos interesantes del Gran Colisionador de Hadrones:

- Ubicación: Frontera Franco-Suiza, cerca de Ginebra (a 100 metros bajo tierra)

- Laboratorio: Centro Europeo de Investigaciones Nucleares (CERN, por sus siglas en francés)

- Objetivo: Recrear las primeras trillonésimas de segundo transcurridas tras la Gran Explosión que dio origen al universo.

- Funcionamiento: El LHC hace colisionar dos protones con una energía cinética total de 14 TeV (Teraelectronvoltios), (o dos iones de plomo a una energía total de 1140 TeV); después detecta y mide, a través de sus 4 experimentos (detectores), las propiedades de las nuevas partículas que se producen cuando la energía cinética se transforma en materia.

- Equipo humano: Más de 10 mil científicos de todo el mundo.

- Experimentos o detectores que lo componen: ATLAS, CMS, LHCb y ALICE.

- ATLAS Investiga una amplia gama de la física, incluyendo al bosón de Higgs y las dimensiones y partículas que podrían conformar la materia oscura. Es en el centro de este detector donde colisionan los haces de partículas.

- CMS Está diseñado para investigar una amplia gama de la física, como la búsqueda del bosón de Higgs, dimensiones extra, y las partículas que podrían conformar la materia oscura. A pesar de que tiene los mismos objetivos científicos que el ATLAS, utiliza diferentes soluciones técnicas y un diseño de imán diferente.

- LHcb Su objetivo es investigar las pequeñas diferencias entre la materia y la antimateria, mediante el estudio de un tipo de partícula llamada “beauty quark” o “quark b”. Se compone por un serie de subdetectores.

- ALICE Es un detector de iones pesados que se encuentra dentro del anillo del LHC. Está diseñado para estudiar la física de la interacción fuerte de materia a altas energías, creando quark-gluon, un estado de la materia que se formó poco después del Big Bang.

*El espín (derivado de la palabra spin, girar, en inglés) es una especie de unidad que determina cómo se muestra una partícula desde distintas direcciones.

La tecnología eficiente ahorra millones

2013/10/02

Según el Fideicomiso para el Ahorro de Energía Eléctrica (FIDE), el uso de tecnología eficiente en casa, podría generar ahorros de 2,875 pesos al año en energía eléctrica.

Hoy en día existen un sinfín de productos y electrodomésticos que ocupamos a diario y que cuentan con esta tecnología que permite tales ahorros. Los más comunes: licuadoras, planchas, refrigeradores, estufas, hornos y televisores.

Una forma fácil de identificar si estás utilizando los productos u aparatos correctos es verificar que cuenten con el Sello Fide, el cual tiene dos versiones que a continuación te exponemos.

- Sello Fide A. Se otorga a equipos eléctricos o electrónicos que utilizan la energía eléctrica eficientemente para realizar un trabajo directamente aprovechable por el usuario (Refrigeradores, lámparas ahorradoras, etc.)

- Sello Fide B. Se otorga a productos que no ahorran energía eléctrica por sí mismos. Se considera para equipos y/o materiales que gracias a su aplicación o instalación, son capaces de crear condiciones que deriven en potenciales ahorros de energía eléctrica (aislantes térmicos, domos, etc.)

El siguiente vídeo se comentan los beneficios en materia de ahorro y uso eficiente de energía eléctrica al adquirir productos con el Sello Fide:

La CFE tiene registrados 31 millones 820 usuarios en la tarifa doméstica, tradicional y de alto consumo, equivalentes al 88.41% del total en el país.

Ver también: Luz sustentable y eficiente

Con el 24.64% de las ventas de la Comisión Federal de Electricidad, los hogares mexicanos ocupan el segundo sector de mayor importancia para la paraestatal, el primer sector es el industrial.

El consumo promedio de electricidad en una vivienda de la zona central del país es de 200 a 500 kilo Watts/hora; en el norte llaga a los 1,400 kW/h debido al uso de aires acondicionados, por lo que el ahorro en estos hogares sería más significativo de ocupar tecnología eficiente.

Cabe mencionar que el uso de equipos eficientes evitaría la emisión de alrededor de 860,500 toneladas de dióxido de carbono al año, que tienen un valor de 4.3 millones de dólares en el mercado de bonos de carbono.

2 alternativas para el tratamiento del agua

2013/09/02

En la actualidad se trabaja en la búsqueda de técnicas que abaraten los procesos aplicados al tratamiento de agua que consumen grandes cantidades de energía, lo que es costoso tanto desde el punto de vista económico como medioambiental.

Como bien sabemos, el problema del desabasto de agua se vuelve más preocupante día a día debido a que el uso del vital líquido es diverso y de gran importancia en muchos procesos. Esto ha llevado a gran cantidad de investigadores a desarrollar métodos para tratar aguas de desecho con la menor cantidad de energía posible.

La energía fotovoltaica produce una corriente eléctrica continua, lo que la hace ideal para su aplicación en dos técnicas de tratamiento de agua: la electrodiálisis y la electroxidación.

- Electrodiálisis

- Electroxidación

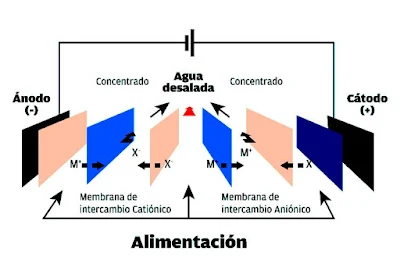

La electrodiálisis es una técnica basada en el transporte de iones a través de membranas selectivas bajo la influencia de un campo eléctrico. En una pila de electrodiálisis convencional se sitúan alternativamente membranas de intercambio catiónico y aniónico, entre el cátodo y el ánodo.

Cuando se aplica una diferencia de potencial entre ambos electrodos, los cationes se mueven hacia el cátodo y los aniones hacia el ánodo. Los cationes migran a través de las membranas de intercambio catiónico, las membranas permiten el paso mediante cationes pero no de aniones y son retenidos por las membranas de intercambio aniónico. Por otra parte, los aniones migran a través de las membranas de intercambio aniónico que permiten el paso por medio de aniones pero no de cationes y son retenidos por las membranas de intercambio catiónico. Estos movimientos producen el aumento en la concentración de iones en algunos compartimentos llamados celdas de concentración y la disminución en los adyacentes que se conocen como celdas de dilución, en la figura siguiente se muestra el transporte de carga en un sistema de electrodiálisis convencional.

Los módulos fotovoltaicos se conectan a bancos de baterías donde la energía producida es almacenada para ser utilizada cuando sea necesario. Conectando estos módulos directamente a la célula de electrodiálisis se reduce sustancialmente el costo de inversión en estos sistemas. La principal razón para la conexión directa a la célula de electrodiálisis es simple: en lugar de acumular energía eléctrica en las baterías para usarla más tarde, el agua tratada durante las horas de luz es almacenada en depósitos, ya que es más barato almacenar agua en tanques que acumular energía en un sistema de baterías.

Además, los sistemas de electrodiálisis son una alternativa a los actuales procesos de desalinización, tales como la ósmosis inversa del agua marina o la evaporación, ya que liberan al mar un flujo de agua cuya concentración salina es similar a la de éste, evitando así los problemas derivados del aumento salino localizado que sí se produce en las plantas de ósmosis inversa y que estropean el frágil ecosistema costero.

El siguiente vídeo ilustra el proceso de electrodiálisis:

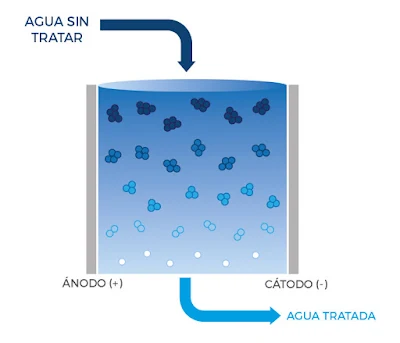

La electroxidación es otra tecnología creada para la oxidación de la materia orgánica disuelta en las aguas residuales. Como tecnología para el tratamiento de aguas, la electroxidación se enmarca dentro del grupo de los Procesos de Oxidación Avanzada (POA) por cuanto es posible generar radicales hidroxilos OH bajo ciertas condiciones de operación y en ciertos electrodos. La electroxidación se considera como una alternativa medioambientalmente viable para el tratamiento de aguas residuales, ya que se puede alcanzar la completa destrucción de la materia orgánica utilizando un reactivo limpio como es la electricidad, reduciendo la producción de lodos y evitando la utilización de compuestos químicos adicionales.

Ver también: El lado positivo de la basura

En los procesos de electroxidación, el afluente a tratar se hace circular por un reactor heterogéneo, entrando en contacto con ánodo y cátodo, en los que tienen lugar respectivamente, las reacciones de oxidación y reducción.

La tecnología de electroxidación trata de hacer frente a aquellas situaciones en las que el afluente residual posee una baja capacidad de ser oxidado, haciendo inviable su tratamiento térmico o bien un bajo nivel de biodegradabilidad, para el que la opción biológica no es viable. Para valores de demanda química de oxígeno por debajo de 5 mg O2·L-1, la electroxidación es una alternativa interesante como POA.

Entre las debilidades de la tecnología cabe destacar los altos costos de inversión y esencialmente el elevado consumo de energía específico por unidad de volumen tratado. Este elevado consumo energético no sólo impacta de forma notable al proceso en cuanto a rentabilidad económica, sino que lo hace fuertemente sobre la sostenibilidad ambiental del mismo.

Los valores de energía consumidos son variables puesto que dependen de la conductividad del agua a tratar y el nivel de eliminación deseado de materia orgánica, es factible encontrar por tanto valores en el rango 10-1000 kWh·m3. Sin necesidad de operar en el valor máximo del rango anterior, queda claro que empleando energía de red y para efluentes degradables donde la electroxidación y los procesos biológicos son tecnológicamente viables, la electroxidación deja de ser económicamente competitiva puesto que el consumo neto de energía en una planta convencional de tratamiento de aguas residuales urbanas se encuentra en el orden de los 0,7 kWh·m3.

|

| De la lista de los 10 principales problemas a los que se debe enfrentar la humanidad en los próximos 50 años, los cuatro primeros son: energía, agua, alimentos y medioambiente. |

5 tipos de vehículos eléctricos

2013/08/30

Para reducir la contaminación se han lanzado una serie de coches que han mostrado un buen rendimiento, incluyendo el eléctrico puro. A continuación te los mencionamos:

- Microhíbridos

Se llaman microhíbridos, porque tienen apoyo eléctrico. Son modelos con mecánicas de combustión convencionales que incluyen el sistema Start&stop de arranque y parada automática en los semáforos y atascos para reducir los consumos y emisiones en ciudad. Y para no agotar la batería convencional con tanto arranque, añaden un dispositivo que recupera la energía de los frenos para recargarla y que pueda absorber el gasto extra que exige alimentar el Start&stop. Las distintas empresas han denominado de diferente forma a esta tecnología, podemos identificarla como Efficient Dynamics en BMW, Bluemotion en VW y Start&stop o Stop&Start en Mazda.

El Audi Q8 2020 es un automóvil eléctrico microhíbrido

- Híbridos clásicos

El coche híbrido eléctrico combina un motor, de momento de gasolina, y otro eléctrico que sirve de ayuda. Incluyen siempre el Start&stop, pero añaden unas baterías extra que se autorecargan con el motor térmico. Recupera la energía cinética de los frenos a través del alternador. Así, además de reducir el trabajo del motor convencional de gasolina, en algunos casos permiten recorrer uno o dos kilómetros sólo en modo eléctrico para no contaminar. Como ejemplos podemos mencionar al Toyota Prius y los Honda Civic Hybrid.

El Toyota Prius es un vehículo híbrido de gasolina y electricidad y el modelo híbrido más vendido en el mundo

- Híbridos enchufables

Llevan unas baterías más grandes y potentes que permiten recorrer los primeros 20 a 40 kilómetros utilizando sólo energía eléctrica almacenada, aunque también puede utilizarse esta energía cuando entres en ciudades con ciertas prohibiciones hacia modelos de combustión (como sucede en Europa). Volvo presentó hace unas semanas el modelo V60 Plug-in Hybrid.

Wolkswagen Golf híbrido enchufable, cuyas baterías pueden ser recargadas usando una fuente externa de energía eléctrica

Ver también: 4 métodos de carga de un vehículo eléctrico

- Eléctricos

Se alimentan únicamente con sus baterías y no emiten ningún gas o sustancia contaminante. Se recargan en enchufes convencionales o en los de carga rápida que se están empezando a implantar en diferentes partes del mundo. El modelo que actualmente podemos ver circular en ciudades como Aguascalientes y la ciudad de México es el Nissan Leaf. También en la ciudad de México actualmente transitan 12 Mini Cooper eléctricos que BMW entregó a funcionarios, investigadores y académicos, como parte de un estudio para ver sus capacidades de movilidad y gasto de energía, entre otros puntos.

El Nissan LEAF es un automóvil eléctrico lanzado en Estados Unidos y Japón en diciembre de 2010

- Eléctricos con autonomía extendida

Son muy parecidos a los híbridos enchufables. Pueden recorrer unos 60 kilómetros con la electricidad de sus baterías y cuando éstas se agotan, cuentan con un motor de combustión convencional. Pero a diferencia de los híbridos clásicos, este motor no mueve al coche. En realidad, actúa como un generador y aporta la electricidad necesaria para poder continuar el viaje con el motor eléctrico, aunque gastando carburante. Los Chevrolet Volt y Opel Ampera, son los pioneros de esta tecnología, que hace compatible el coche eléctrico con los viajes.

El Chevrolet Volt es un vehículo eléctrico de autonomía extendida desarrollado por General Motors lanzado en Estados Unidos en diciembre de 2010

Es cierto que en nuestro país actualmente comprar un carro con esta tecnología es caro (cuando se adquiere, pero no por mantenimiento) y la oferta comercial muy poca, aunado a que no existe en todo México la infraestructura adecuada para permitir la movilidad que requieren los usuarios.

Por ello, la empresa Nissan ha declarado que se encuentran en negociaciones para que los usuarios tengan un costo preferencial del consumo de electricidad. La CFE propone instalar una toma exclusiva en los hogares de quienes tengan un Leaf para distinguir el consumo del vehículo, así como la posibilidad de acceder a cuotas preferenciales en peajes y carriles exclusivos.

De igual forma es necesario que existan incentivos por parte del Gobierno Federal, como sucede en Estados Unidos, donde este coche tiene un costo de 39 mil dólares (542, 880 pesos aproximadamente), pero se goza de un incentivo de 10 mil dólares, por lo que su precio final para el usuario es de 29 mil dólares (403, 680 pesos), más el costo-beneficio del uso de electricidad en lugar de gasolina; en México se calcula que por cada 160 km se pagarían en promedio 40 pesos de electricidad, ahorrándose un poco más de 70 pesos, puesto que para recorrer esos mismos kilómetros se requieren 112 pesos de gasolina.

Sin embargo, ya se están dando los primeros pasos y esperamos que en unos 20 años más podamos ver circular al menos el 50% de la flotilla de autos con alguna de estas tecnologías. El ambiente nos lo agradecerá.

4 métodos de carga de un vehículo eléctrico

Para recargar las baterías de un coche eléctrico es necesario conectarlo a la red eléctrica. En promedio este proceso tarda entre 4 y 8 horas para completarse (cuando se cuenta con una toma de 220V). Hoy en día se trabaja en diferentes métodos de recarga:

- Recarga lenta en estaciones de baja potencia. La recarga se efectúa en estaciones de potencia eléctrica normal. Esta recarga tarda varias horas, por lo que durante ese periodo el consumidor puede realizar diversas actividades.

- Lenta, doméstica y nocturna. Esta opción propone que sea el consumidor quien recargue el vehículo en su propia casa conectándolo a la red eléctrica de su hogar durante la noche. De esta forma cuando lo toma en la mañana el vehículo está ya totalmente recargado y listo para usarse.

- Rápida en estaciones de alta potencia. Se plantea la instalación de estaciones especiales en las cuales las baterías de los coches eléctricos se puedan recargar en pocos minutos. Para ello se requiere intensidades eléctricas muy superiores a las habituales de la red.

- Rápido de intercambio de baterías. Otra opción propuesta es la sustitución de las baterías en estaciones de recarga. La dinámica consistiría en que el consumidor acude a la estación con su batería con carga baja y se le sustituiría por una totalmente recargada. La batería no sería propiedad del dueño del coche, sino de las estaciones de recarga (o de la compañía que las operase).

El siguiente vídeo nos muestra todo lo que debemos saber a la hora de efectuar la recarga de un coche eléctrico:

5 componentes principales de los vehículos eléctricos

En un futuro no muy lejano será cotidiano ver circular una buena cantidad de coches eléctricos en nuestro país, cuya eficiencia y ventajas están siendo probadas en diferentes partes del mundo.

Uno de los sectores que continuamente está evolucionando es sin duda el del transporte. Las exigencias del mundo cada vez son más elevadas, por lo que se requiere rendimiento y a la par menor generación de contaminantes.

Teniendo en cuenta estos puntos surgieron los coches eléctricos actuales, aunque en realidad se tienen datos de su existencia desde mucho tiempo atrás, entre 1832 y 1839, periodo en el cual Robert Anderson inventó el primer carruaje de tracción eléctrica, con pila de energía no recargable.

Un coche eléctrico es aquel que se impulsa con la fuerza que produce un motor alimentado por electricidad. A continuación te explicamos los componentes principales del vehículo eléctrico:

- Motor eléctrico Se encarga de transformar la energía eléctrica proveniente de las baterías. Puede tener uno o varios, dependiendo del diseño. Los motores eléctricos son sin escobillas y están alimentados totalmente por la electricidad almacenada en las baterías.

- Baterías Es la fuente de energía del vehículo. Almacenan la energía eléctrica que va a servir para accionar el motor de manera semejante a como lo hace un depósito de gasolina. Existen diferentes tecnologías, desde las más sencillas de Plomo-Ácido (Pb-Ácido), hasta las más avanzadas de Ionlitio (Ion-Li), pasando por otras tecnologías intermedias como la de Níquel Hidruro metálico (NI-MH) o la de Níquel-Cadmio (Ni-Cd).

Ver también: Los motores eléctricos

- Puerto de carga Es el lugar por el que recargamos de electricidad el automóvil. Se trata de una toma exterior. Puede haber otra toma, pero de carga rápida (como un enchufe trifásico). En un principio cada marca ha creado su conexión particular aunque ya existen propuestas para estandarizar las conexiones a fin de simplificar la recarga de las baterías.

- Transformadores Son los encargados de transformar los parámetros de la corriente eléctrica (intensidad y voltaje) desde las características que presenta la red eléctrica o un punto de recarga rápido hasta las necesarias para recargar adecuadamente las baterías. También contribuyen a la refrigeración con la que se evitan derrames y accidentes.

- Controladores Regulan la entrada de energía a la batería y permite una recarga adecuada evitando que ésta se pueda sobrecargar y deteriorarse.

La primer ventaja que ofrecen los motores eléctricos es un menor tamaño y peso, además de una mayor sencillez técnica (tienen menos componentes y piezas que el de combustión). Su rendimiento frente a los de combustión es más elevado.

Cabe mencionar que mientras que los motores de combustión transforman aproximadamente el 30% de la energía que reciben, los motores eléctricos alcanzan hasta un 80%, además ofrecen un par constante, por lo que empujan desde muy bajas revoluciones y son respetuosos con el medioambiente, ya que no emiten dióxido de carbono (CO2) ni ruidos (contaminación acústica).

Elevadores ecológicos

2013/06/03

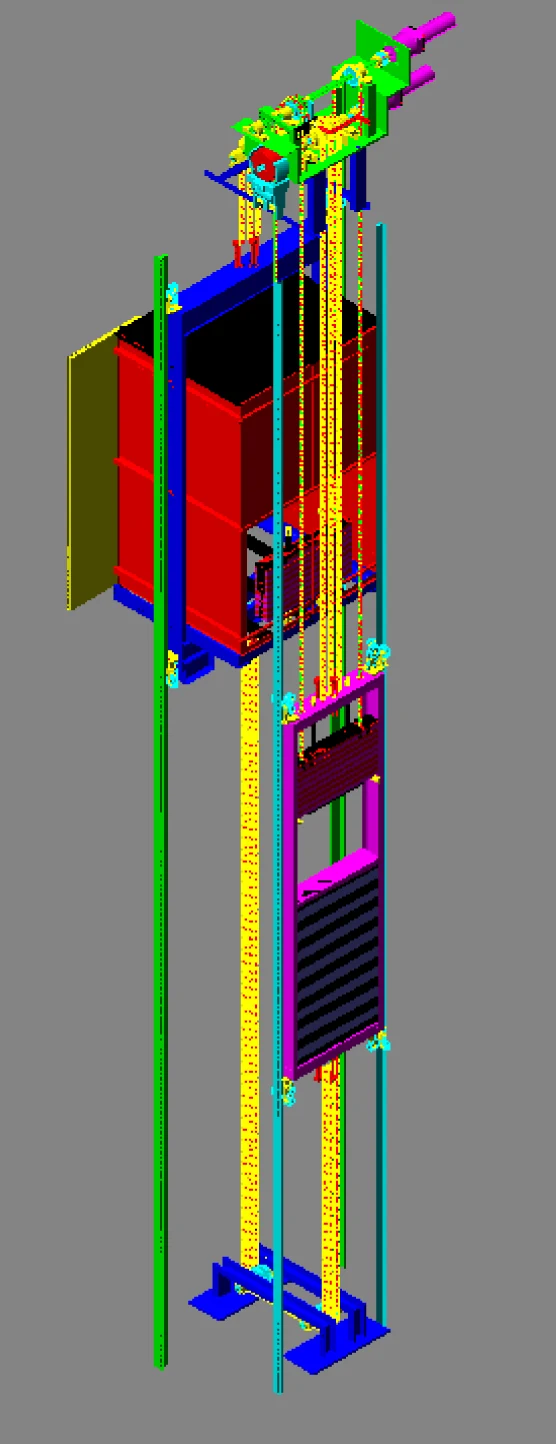

Científicos mexicanos desarrollan tecnología de vanguardia con ascensores gravitacionales que disminuyen el uso de energía eléctrica entre 70 y 90 %.

Aunque se creía que casi todo estaba escrito sobre la forma de mover una carga verticalmente, en México se está desarrollando una nueva tecnología para crear elevadores de energía gravitacional, en una industria que tiene una evolución de más de 150 años y que ha llegado a un punto en el que las mejoras potenciales cada día son menores.

Mediante esta nueva tecnología se obtiene la energía para mover un ascensor a partir de la gravedad, alineándola en favor del movimiento en lugar de pelear con ella. Un equivalente de este principio sería la caricatura en la que dos mulas están atadas por el cuello entre sí y ambas quieren caminar en diferentes direcciones sin lograrlo, pues sólo se moverán si una de ellas es más fuerte que la otra; en cambio, cuando ambas deciden moverse en el mismo sentido, la eficiencia es máxima con el menor consumo de energía.

En el caso que nos ocupa, faltaba disminuir el consumo de la energía mediante el uso de un contrapeso, cuyo efecto estaba limitado a cierto valor de disminución de energía, debido a que las condiciones de su dimensionamiento tenían serias limitaciones respecto a si el elevador viaja hacia arriba o hacia abajo o vacío, con carga media o completa.

Para entender mejor este principio, ejemplifiquemos con el "subeybaja", que finalmente es un elevador de niños. Si únicamente consideramos a un pequeño en un extremo, la energía necesaria para subirlo es muy importante pues hay que ejercer una gran fuerza. Si ponemos a dos infantes, uno en cada extremo, con pesos diferentes, habremos disminuido el consumo de energía, aunque ésta no será la misma para subir que para bajar. Este es el caso de los elevadores existentes, pues la carga en la cabina es permanentemente cambiante y su movimiento se tiene que suplir mediante el consumo de electricidad.

La nueva tecnología de los elevadores de energía gravitacional logra que éstos entren en constante balance entre la carga del lado de la cabina y sus pasajeros, y el otro lado representado por el contrapeso. Esto se obtiene con contrapesos de carga variable, que logran mediante mecanismos simples, pero muy inteligentes, ese equilibrio tan deseado bajo cualquier circunstancia, de manera que sólo se necesita un pequeño desbalance de la carga en un sentido o en el otro para lograr el movimiento, venciendo con esto las pérdidas por fricción.

Lo anterior se logra mediante la robótica, que hoy en día está al alcance de cualquier industria y que sin duda alguna representa el futuro para lograr movimientos rápidos, exactos y seguros que, combinados con el balance permanente, dan como resultado la eliminación de la fuerza motriz eléctrica casi en su totalidad, pues ésta sólo se requiere para mantener el control programado del movimiento y una pequeña parte para mantener las condiciones del mismo, lo que genera ahorros de entre 70% y 90% en energía, con un potencial incluso superior si se fabrican cabinas de muy bajo peso (de aluminio o de fibra de carbono) para que el consumo energético sea casi nulo.

Ver también: El transporte eléctrico en México y el mundo

Recientemente se ha creado una nueva empresa mexicana denominada Elevadores Gravitacionales, que ya instala un segundo elevador con esta tecnología en el edificio del Fideicomiso para el Ahorro de Energía Eléctrica (FIDE) -después de haber sorprendido con los resultados del primero, instalado en la Plaza Narvarte- para que sea certificado el ahorro mencionado y, con ello, promover el uso de estos ascensores entre los usuarios mexicanos, sobre todo en aquellas aplicaciones de tráfico medio e intenso, que es donde sus beneficios son incluso mayores.

Se trata de llegar no únicamente al usuario nacional sino al internacional, lo cual se logrará mediante el licenciamiento de esta tecnología a las grandes empresas fabricantes de elevadores, en un momento en el que hay gran preocupación mundial por el cambio climático y un creciente encarecimiento de los combustibles.

Este invento, cuyo principio ya ha sido solicitado para la obtención de patentes nacionales e internacionales, representa un nuevo concepto sobre cómo deberán ser los elevadores en el futuro: no sólo ahorradores de energía, sino notablemente seguros, con pocas necesidades de mantenimiento, con incremento en la precisión y monitoreo remoto en tiempo real, a fin de conocer en forma permanente las condiciones de operación y diagnosticar alguna falla real o potencial mediante el uso de la red existente de Internet. También podrán llegar a un destino aun cuando exista una falla en el suministro eléctrico; esto último les concedería enormes ventajas con respecto a las tecnologías tradicionales, así como otras en proceso de desarrollo.

Entre los objetivos a corto plazo de Elevadores Gravitacionales está iniciar la fabricación en serie de este tipo de ascensores tanto para modernizar los existentes, como para los nuevos proyectos tipo LED; además, convencer a las autoridades de que instalen aparatos con esta tecnología en los puentes peatonales, para uso de todo público, pues de acuerdo con documentos oficiales, sólo en 2006 hubo 4 mil 992 personas atropelladas. Entre 2000 y 2007 murieron más de 50 mil peatones y, por cada fallecido, 30 quedan con lesiones.

Con la instalación de los elevadores gravitacionales se beneficiarían especialmente los discapacitados, las personas de la tercera edad y las que tienen sobrepeso, las madres con niños y con carriolas, además del público en general. También se resolverían problemas de tránsito y habría menos tiempos perdidos.

Los creadores de esta tecnología somos profesionistas mexicanos: Rodolfo Zamorano Morfín, Alberto Cornejo Lizarralde y Roberto Domínguez Burguete, quienes con un trabajo de más de cinco años, hemos logrado hacer realidad este nuevo tipo de elevador, en beneficio de la humanidad y de nuestro planeta.

|

| Ing. Rodolfo Zamorano Morfín presentado su proyecto de elevador ecológico gravitacional |

Pasado y presente de la Fibra óptica

2013/05/17

La creación de la fibra óptica ha permitido grandes adelantos en el campo de las comunicaciones. Tan sólo en México, el par de hilos propiedad de CFE tiene la capacidad para permitir 50 millones de llamadas simultáneas. Pero su invención no ha sido fácil, es el trabajo de muchos investigadores y la realización de ideas visionarias.

La fibra óptica es utilizada para la transmisión de imágenes e información, y precisamente porque es la base de la nueva tecnología de la comunicación, influye en nuestra vida cotidiana.

La fibra óptica es un filamento cilíndrico transparente, fabricado en vidrio, que posee la propiedad de propagar las ondas electromagnéticas colocadas en el espectro visible.

La comunicación entre dispositivos electrónicos se realiza a través de ondas electromagnéticas.

Cuanto mayor es la frecuencia de la onda, mayor es la cantidad de información que puede ser transmitida. Dado que la luz es también una onda electromagnética, cuya frecuencia es muy elevada, el flujo de información que transporta es, consecuentemente, muy superior al que se obtendría utilizando otros tipos de ondas.

Las fibras ópticas están formadas por dos elementos: un núcleo cilíndrico y una funda envolvente, denominada vaina. Ambos componentes se fabrican en vidrio, aunque siguiendo procesos distintos, puesto que es necesario que el índice de refracción difiera en uno y otro. El núcleo está formado por el vidrio más puro. Por éste viaja la luz. El revestimiento impide su propagación al interior del cable dirigiéndola sin distorsiones incluso en curvas. De este modo, la velocidad a la que viajan las ondas es distinta en el núcleo y en la vaina. La mezcla del vidrio con materiales impuros determina las variaciones en el índice de refracción, éste consiste en que cuando un haz de luz que se propaga por un medio ingresa a otro distinto, una parte del haz se refleja mientras que la otra sufre una refracción, es decir un cambio de dirección del haz. Para esto se utiliza el llamado índice de refracción del material, que nos servirá para calcular la diferencia entre el ángulo de incidencia y el de refracción del haz (antes y después de ingresar al nuevo material). El índice de refracción del material con el que está fabricada caracteriza a la fibra.

El diámetro de una fibra óptica oscila entre los 10 y los 100 micrómetros (un micrómetro equivale a la millonésima parte de un metro); la unión de fibras ópticas determina la formación de haces que pueden ser rígidos o flexibles, y transmitir tanto la luz como imágenes o informaciones, dependiendo de las aplicaciones. Han sido mejoradas para llevar varias longitudes de onda de la luz en la misma fibra, lo que incrementa enormemente su capacidad de comunicación.

Ventajas

- Las principales ventajas de este conductor son su reducido grosor y la gran efectividad que demuestra en la transmisión de datos.

- No sufre alteraciones electromagnéticas (contrariamente a lo que les sucede a los cables convencionales de cobre).

- Pueden incluirse en un cable contenedor muchísimas fibras ópticas sin pérdidas en la transmisión aunque la conexión esté separada por decenas de kilómetros.

- Como el medio para transmitir los datos es la luz, permite una mayor velocidad en la transmisión a larga distancia.

- Hay de diferentes grosores, desde el equivalente a un cabello humano hasta unas 10 veces más delgado.

Aplicaciones

- En medicina, hizo posible la invención del endoscopio, que permite iluminar, en cirugías, zonas pequeñas en el interior del cuerpo humano.

- En la industria y la mecánica brindó las mismas posibilidades de iluminación que en la medicina: facilitó la llegada a lugares difíciles como turbinas o artefactos con zonas oscuras.

- En las telecomunicaciones aumentó las velocidades y la calidad de llamadas telefónicas, internet y otras formas de conexiones. Une continentes con cables transoceánicos.

- Aparecen fibras ópticas en diferentes objetos de decoración, como árboles de navidad.

- En algunas edificaciones se diseñan originales alternativas de iluminación, lo que permite un bajo consumo de energía.

- Los cables de fibra óptica también se utilizan como sensores en la medición de temperatura, presión, tensión y también en sismos.

En 1964 Stewart Miller, de los Laboratorios Bell, dedujo maneras detalladas de demostrar el potencial del cristal como medio eficaz de transmisión a larga distancia. Aunque en la industria y en la medicina ya se utilizaban filamentos delgados como el pelo para transportar luz a distancias cortas y a lugares que de otra forma serían inaccesibles, la luz perdía normalmente hasta el 99% de su intensidad al atravesar distancias tan cortas como 9 m.

Ver también: Conceptos básicos de nanotecnología

En 1966, Charles Kao y George Hockham, de los Laboratorios de Standard Telecommunications en Inglaterra, afirmaron que se podía disponer de fibras de transparencia mucho mayor. En un artículo demostraron que las grandes pérdidas características de las fibras existentes se debían a impurezas diminutas presentes en el cristal, principalmente agua y metales, en lugar de las limitaciones propias del cristal. Pronosticaron que la pérdida de la luz en las fibras podría disminuir enormemente de 1000 decibelios a menos de 20 decibelios por kilómetro. Con esta mejora, se podrían colocar amplificadores para aumentar la señal luminosa a intervalos de kilómetros, en lugar de metros, a distancias comparables a las de los repetidores que amplificaban las señales débiles en las líneas telefónicas convencionales.

El artículo estimuló a una serie de investigadores para producir fibras de baja pérdida. El gran avance se produjo en 1970 en Corning Glass Works, cuando Donald Keck, Peter Schultz y Robert Maurer lograron fabricar con éxito una fibra óptica de cientos de metros de largo con la claridad cristalina que Kao y Hockham habían propuesto. Poco después, Panish y Hayashi, de los Laboratorios Bell, mostraron un láser de semiconductores que podía funcionar continuamente a temperatura ambiente, y John MacChesney y sus colaboradores, también de los Laboratorios Bell, desarrollaron independientemente métodos de preparación de fibras.

La primera prueba se realizó en AT&T en Atlanta en 1976. Los equipos de trabajo instalaron dos cables de fibra óptica, cada uno de los cuales medía 630 metros de largo y contenía 144 fibras, tirando de ellos a través de conductos subterráneos estándar, se requería que los cables pudieran sortear curvas cerradas. Para alivio de todos, no se rompió ninguna fibra durante la instalación, ni las curvas cerradas degradaron su rendimiento. El servicio comercial comenzó al año siguiente en Chicago, donde un sistema de fibra óptica transportaba voz, datos y señales de vídeo a través de 2.4 km de cables subterráneos que conectaban dos oficinas de conmutación de la compañía telefónica de Illinois, Bell Telephone Company.

Estas actividades marcaron un punto decisivo, pues gracias a ellas se contaba con los medios para llevar las comunicaciones de fibra óptica fuera de los laboratorios de física al campo de la ingeniería habitual. Durante la siguiente década, a medida que continuaban las investigaciones, las fibras ópticas mejoraron constantemente su transparencia.

En 1980 las mejores fibras eran tan transparentes que una señal podía atravesar 240 km de fibra antes de debilitarse hasta ser indetectable. Si los mares del mundo fuesen tan transparentes, se podría navegar por las zonas más profundas del Pacífico y observar el fondo del océano tan fácilmente como el fondo de una piscina.

Una cuestión importante en el desarrollo de la fibra ha sido el perfeccionamiento de sus métodos de fabricación, por ejemplo, el cristal de sílice puro, sin ninguna impureza de metal que absorbiese luz, se fabricaba directamente a partir de componentes de vapor, con lo que se evitaba la contaminación resultante del uso convencional de los crisoles de fundición.

No obstante, un sistema de comunicaciones de nivel comercial necesitaba algo más que una buena fibra. Los láseres todavía no eran muy fiables y fallaban tras unas cuantas horas de funcionamiento. Además, aún no existía ninguna forma económica de producir láseres fiables en las cantidades requeridas.

Una vez más, era necesario recurrir al trabajo del laboratorio de investigación. Dos investigadores de los Laboratorios Bell, J.R. Arthur y A.Y. Cho, idearon un método diferente de desarrollo de cristales, llamado epitaxia de rayo molecular o MBE (del inglés Molecular-Beam Epitaxy). Epitaxia es el desarrollo de cristales de un mineral sobre la superficie de los cristales de otro mineral y el método MBE era tan preciso que permitía colocar una capa de material semiconductor de espesor medido en átomos. Al reducir los electrones y la luz que emitían, esta capa extremadamente fina demostró su gran eficacia para generar la actividad del láser a la vez que se utilizaba menos corriente eléctrica y, mejor aún, los nuevos dispositivos de MBE consiguieron tener una vida útil de 1 000 000 de horas.

En los primeros sistemas de fibra óptica, los amplificadores para regenerar señales débiles constituían un cuello de botella. Pero en 1985, en la Universidad de Southampton en Inglaterra, un físico llamado S.B. Poole descubrió una solución. Añadiendo una cantidad pequeña del elemento erbio al cristal utilizado en las fibras ópticas se podía construir un amplificador completamente óptico.

En 1988 se tendió el primer cable submarino entre Estados Unidos y Europa.

En 1991, los investigadores de los Laboratorios Bell demostraron que un sistema completamente óptico tendría una capacidad de transporte aproximadamente cien veces superior a la que se podía lograr con amplificadores electrónicos. Los primeros cables totalmente ópticos comenzaron a funcionar en 1996 a través del Atlántico y en el Pacífico.

El premio Nóbel de Física 2009 fue otorgado al físico chino Charles Kao. "Nadie en su sano juicio pensó que se podría enviar una señal a través del cristal", dijo el historiador Robert Colburn, que entrevistó a Kao para el IEEE en 2004. "Kao desafió el saber convencional de la época prediciendo que se podría hacer el cristal lo suficientemente puro. La gente decía: 'No se puede ver a través de un vidrio de un pie de espesor, mucho menos en uno de mil kilómetros de largo.'"

A pesar de todo, Kao perseveró en su teoría, y cuatro años más tarde, estas fibras se producían por Corning, en el estado de Nueva York. Hoy en día las fibras ópticas transmiten datos a velocidades asombrosas. Bell Labs rompió el récord de transmisión vía fibra óptica, enviando el equivalente de 400 DVD por segundo a 7000 kilómetros, superando a los cables submarinos comerciales por un factor de 10. Sin la tecnología desarrollada por Kao no existiría internet ni las comunicaciones telefónicas en la magnitud y a los precios que las tenemos en la actualidad.

En México hubo una licitación por la concesión del par de hilos de fibra óptica oscura propiedad de CFE, el cual tiene capacidad suficiente para absorber la demanda de servicios de telecomunicaciones del país por los próximos diez años.

De acuerdo con el director de estudios en regulación del ITAM, Ramiro Tovar Landa, el par de hilos de fibra oscura es suficiente para transmitir 800 megabits por segundo (Mbps). Esa capacidad es equivalente a cursar 50 millones de llamadas telefónicas simultáneas o soportar 400 000 enlaces dedicados, que permiten sostener conexiones permanentes a internet.

En la actualidad se han colocado más de 1000 millones de kilómetros de fibra óptica en todo el mundo, lo que, si se los uniera, equivaldría a dar 25 000 vueltas al mundo. Las fibras ópticas de vidrio cargan con casi la totalidad del tránsito de comunicaciones telefónicas y de datos en el mundo.

Indiscutiblemente, el progreso ha sido notable y rápido. Sin embargo, se vislumbran avances aún más impresionantes en el horizonte. Aunque los sistemas de fibra óptica actuales funcionan como líneas troncales, transportando un gran número de canales de voz y datos entre centrales telefónicas, los especialistas de la industria hablan con pesar de la "última milla": desde la centralita hasta los hogares. El sistema telefónico actual atraviesa esta última milla con equipos de hilo de cobre convencionales, que proporcionan buenas conexiones de voz, pero todavía no están capacitados para transportar grandes cantidades de datos a gran velocidad.

Acerca de fibra óptica experimental, varias que contienen cristales fotónicos y otras estructuras inusuales prometen enviar aún más datos a través de internet. Los cristales fotónicos, por ejemplo, redirigen la luz mucho más rápido que las fibras ópticas, haciendo posible la utilización de cristales para la orientación de la luz dentro de los microchips (fotónicos), lo que aumentaría la capacidad de cómputo de los mismos.

Conceptos básicos de nanotecnología

2013/04/23

Muchas veces confiamos demasiado en nuestros sentidos y creemos que algo no existe o no es posible porque no podemos verlo, sin embargo, una revolución se está llevando a cabo en lugares que nunca lo hubiéramos separado.

La nanotecnología es una de las ramas de la tecnología aplicada con un futuro muy prometedor. Empecemos por aclarar su nombre: el prefijo nano hace referencia a la milmillonésima parte de un metro, un átomo es la quinta parte de eso, es decir que si colocáramos cinco átomos en línea sumarían un nanómetro. Para darnos una idea, comparando un nanómetro con un metro la proporción sería la de una canica con el planeta Tierra, otro ejemplo sería la cantidad de barba que le crece a un hombre en el breve lapso que le toma levantar el rastrillo hacia su cara.

La nanotecnología se ocupa del estudio, diseño, creación, síntesis, manipulación y aplicación de materiales, aparatos y sistemas funcionales a través del control de la materia en una escala molecular y nano, es decir, de 100 nanómetros o más pequeños.

Sus inicios están en la conferencia “Hay mucho espacio en el fondo” (There’s Plenty of Room at the Bottom, en inglés), impartida el 29 de diciembre de 1959 por el físico y divulgador de la ciencia Richard Feynman, en ella auguraba una gran cantidad de descubrimientos y posibilidades si se pudiera fabricar materiales de dimensiones atómicas o moleculares.

Feynman describía un proceso mediante el cual podría llegarse a la capacidad de manipular átomos y moléculas utilizando las herramientas precisas para construir y operar otro equipo más pequeño y así sucesivamente, hasta obtener el tamaño requerido. Mientras esto sucedía él notó que se presentaban cuestiones relativas al tamaño: la gravedad se volvía menos importante, la tensión superficial o las fuerzas de atracción y repulsión entre moléculas se volverían cada vez más significativas. Sin embargo, tuvieron que pasar varios años para que los avances en las técnicas experimentales culminaran en los años ochenta con la aparición del Microscopio de Efecto Túnel (STM), que condujo al descubrimiento de los fulerenos en 1985 y a los nanotubos de carbono, unos años después. El Microscopio de Fuerza Atómica (AFM) fue inventado seis años después. Ambos han hecho posible observar los materiales a escala atómica y después manipular átomos individuales.

A esta escala las propiedades de los materiales, como la conductividad o el magnetismo, cambian, por ejemplo, el color está determinado por longitudes de onda que son demasiado grandes para estos tamaños. Digamos que un material a escala normal tiene cuatrillones de átomos (un cuatrillón=1024), cuando esa cifra disminuye a unos cuantos cientos, su esencia cambia.

Conociendo las propiedades de los átomos se pueden organizar de una manera determinada, uno por uno, lo que resulta en materiales de condiciones predeterminadas, los cuales pueden no encontrarse en la naturaleza.

|

| Los virus se pueden considerar nanoparticulas naturales |

Los nanomateriales son aquellos que tienen propiedades únicas provenientes de sus dimensiones de nanoescala, veamos un ejemplo:

La alotropía es la propiedad química que poseen determinados elementos de presentarse bajo distintas estructuras moleculares. Se encuentra en elementos que tienen una misma composición, pero aspectos diferentes, debe presentarse en el mismo estado de la materia y es característico del sólido. Pongamos por caso el carbono, que se presenta como grafito, diamante y fulereno. La explicación de sus diferencias la hallamos en cómo están dispuestos los átomos en el espacio: en el diamante cada átomo se une a otros cuatro y están ordenados en forma de tetraedro, lo que lo da la dureza; en el grafito los átomos están dispuestos en capas superpuestas, cada átomo está unido a otros tres de la misma capa con más intensidad y a uno de la capa próxima en forma más débil, esto es lo que explica por qué el grafito es blando y untuoso al tacto.

Los nanotubos de carbono son una variedad alotrópica del carbono, como el grafito o el diamante. Su estructura se puede considerar procedente de una lámina de grafito enrollada sobre sí misma, según el grado de enrollamiento y la estructura de la lámina original, puede haber tubos de distinto diámetro y geometría interna.

Ver también: La materia y el átomo

Tienen un amplio margen de comportamiento desde un punto de vista eléctrico, pueden ser desde semiconductores hasta, en algunos casos, superconductores, esto se debe fundamentalmente a relaciones geométricas, es decir, en función de su diámetro, torsión y número de capas. Dentro de sus propiedades mecánicas encontramos que la estabilidad y robustez que existe entre los enlaces de los átomos los hacen la fibra más resistente que se puede fabricar hasta el día de hoy. Son capaces de deformarse notablemente y mantener un régimen elástico; es comúnmente aceptada la afirmación de

que los nanotubos son diez veces más resistentes que el acero, y seis veces más ligeros, aunque se trata de un material todavía poco conocido, y estos valores podrían variar.

Existen dos enfoques principales en nanotecnología: el de bottom up, en el cual lo que se busca es a partir de componentes más pequeños crear montajes complejos; el otro es el de top down, que busca crear dispositivos más pequeños a partir de otros más grandes que se ocupen de su ensamblaje.

La nanotecnología todavía no se ha introducido en la producción industrial, sin embargo, ya existen algunas aplicaciones prácticas, por ejemplo, por su gran capacidad como conductores y emisores de electrones se está investigando para poder incorporar esta tecnología en las pantallas de las computadoras o televisiones; en Estados Unidos se ocupan tubos de carbono de tamaño nanométrico para la iluminación de estadios, o en Japón se fabrican paneles luminosos a partir de materiales semiconductores con nanoestructuras.

Por la poca energía que consumen los dispositivos de este tipo y por la facilidad para colocarlos en cualquier lugar, se espera que lleguen a estar presentes en todos los ámbitos de nuestra vida cotidiana. Las posibilidades van desde dispositivos que permitan que los tejidos de la ropa detecten las condiciones ambientales y se vuelvan permeables o impermeables, hasta sistemas que detecten la existencia de células cancerosas y las eliminen; ya existe un plástico que se autoregenera cuando se rompe, su composición nanométrica consta de esferas de dos tipos, unas contienen una resina y las otras el catalizador correspondiente, cuando el plástico se quiebra también lo hacen las esferas y sus contenidos se mezclan como en un pegamento epoxi (los que constan de dos materiales que, al mezclarse, se endurecen).

La nanotecnología involucra a la Química, la Bioquímica, la Biología molecular, la Física, las Matemáticas, la tecnología de la Ingeniería Electrónica, la Informática y muchas otras, por lo que se la ve como un campo multidisciplinar y de convergencia de ciencias altamente especializadas, asimismo se cree que puede tener gran influencia en la economía, los sistemas de producción, las guerras y la vida cotidiana.

Una gran cantidad de preguntas y preocupaciones han surgido por los posibles efectos y aplicaciones que la nanotecnología podría tener, así como por las medidas que deben ser tomadas para prevenir riesgos. El Centro para la Nanotecnología Responsable (CRN, por sus siglas en inglés) sugiere que los nuevos desarrollos podrían resultar en armas de destrucción masiva que no se podrían rastrear, cámaras controladas por el gobierno o armas diseñadas lo suficientemente rápido como para desequilibrar la carrera armamentista.

La investigación en nanotoxicología indica que uno de los campos de atención deben ser los efectos que la producción y el uso a nivel industrial de nanomateriales podrían tener en la salud de la humanidad y el ambiente. Grupos como el CRN recomiendan que la nanotecnología, por las razones mencionadas, sea especialmente regulada por los gobiernos. Otros grupos argumentan que la regulación exagerada entorpecería las investigaciones que podrían ayudar en gran manera a la humanidad.

Algunos de los productos con nanopartículas recientemente creados pueden tener consecuencias imprevistas. Los investigadores han descubierto que las nanopartículas de plata utilizadas en los calcetines para evitar el mal olor, son liberadas cuando son lavados con posibles consecuencias negativas. Estas partículas podrían destruir las bacterias que son benéficas para descomponer la materia orgánica en las plantas de tratamiento de desperdicios o granjas.

Cabe mencionar que muchas de las aplicaciones de la nanotecnología todavía son hipotéticas y están en fase de investigación y desarrollo, éstas son algunas de las más prometedoras:

- Limpieza del agua: filtros físicos con poros de escalas nanométricas podrían eliminar el 100% de las bacterias y virus.

- Almacenamiento, producción y conversión de energía.

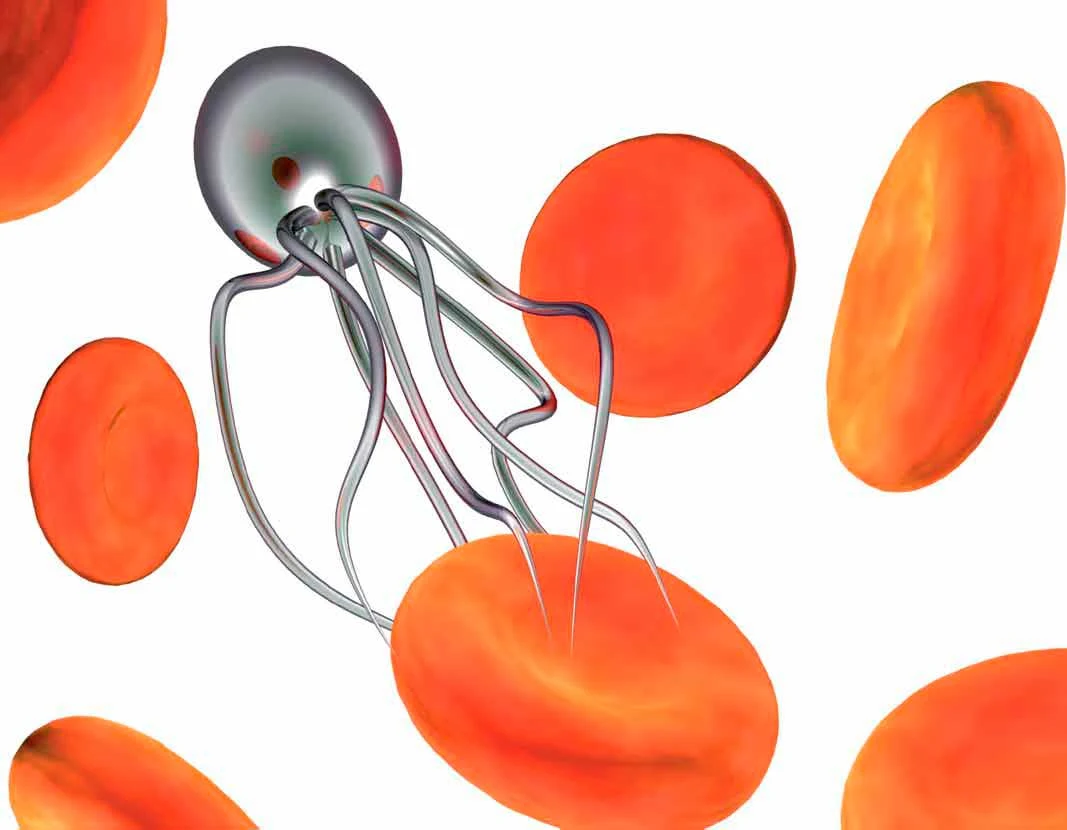

- La nanorobótica es una rama todavía hipotética, se ocuparía de diseñar y crear robots en una escala nano, una de sus aplicaciones potenciales estaría en la nanomedicina y consistiría en el diagnóstico anticipado y combate del cáncer. Se espera poder inyectar al paciente estos nanorobots para combatir las células malas, también podrían tener otras aplicaciones como microcirugías o administrar medicamentos.

- Para remediar la contaminación atmosférica.

- Producción agrícola.

- Para el procesamiento de alimentos, etcétera.

Su impacto podría ser comparable al de la Revolución industrial, pero a diferencia de aquélla, los efectos de ésta no pueden ser previstos en pocos años y la humanidad está desprevenida ante tales riesgos:

- Puede ocurrir una nueva carrera armamentista, una competencia entre países por desarrollar armas y aparatos de espionaje que sean más pequeños, potentes y numerosos.

- La sobreexplotación de productos baratos podría causar graves daños al medio ambiente.

- La producción poco costosa y la multiplicidad de diseños en los productos podría generar grandes cambios en la economía.

- Según el CRN, algunas consecuencias podrían poner en riesgo la existencia de la humanidad, otros podrían producir grandes cambios sin causar la extinción de la especie; una combinación de varios podría empeorar la gravedad de cada uno y las soluciones que se plantean deben tomar en cuenta el impacto que tendrían sobre los demás.

Suscribirse a:

Entradas (Atom)